いま世界で最も注目を集める半導体メーカーといえば「NVIDIA(エヌビディア)」です。かつてはゲーム用グラフィックスカードのイメージが強かったNVIDIAですが、現在では生成AIやディープラーニング、自動運転、医療、金融など多くの分野を支える「AI時代のインフラ企業」としての地位を確立しました。

同時に、NVIDIA製GPUを搭載したサーバーは「AI時代の不動産資産」とも呼ばれ、投資対象として世界中の企業や投資家から注目を集めています。

NVIDIA社は特に高性能GPU技術において圧倒的な市場シェアを誇り、データセンター向けGPU事業だけで約870億ドルの売上を見込んでいます。時価総額も業界トップクラスを維持し、AI・クラウドコンピューティングの成長とともにさらなる拡大を遂げています。

弊社では、NVIDIA製のGPUサーバーを元にしたデータセンター事業を活用した節税対策をご紹介をしております。購入費用を即時償却できる中小企業経営強化税制の対象となっているとともに、他の繰延節税に比べて短期で高収益を期待できる事業です。

さらに、2025年12月に発売された最新版GPUサーバー「NVIDIA RTX PRO 6000 Blackwell Server Edition」も取り扱っております。

ご興味のある方は、お気軽に個別相談会にご参加ください。

NVIDIAとは何か?世界を変えるテクノロジー企業

NVIDIAの企業概要と歴史

NVIDIAは1993年にアメリカ・カリフォルニア州で設立されました。当初はPCゲーム向けのグラフィックスカード市場をターゲットとしており、「GeForce」シリーズは世界的に大ヒットしました。

しかし、その後NVIDIAは単なるGPUメーカーから脱却します。2006年にCUDA(統合型開発環境)を発表し、GPUをグラフィックスだけでなく「汎用計算」に活用する道を切り開きました。これが現在のAI分野での圧倒的な優位性につながっています。

現在、NVIDIAは「AI・データセンター」「自動運転」「ヘルスケア」「産業オートメーション」など幅広い市場に進出しており、世界を変えるテクノロジー企業としての地位を確立しています。

AI時代を支えるNVIDIAの主力製品

NVIDIAの代表的な製品は以下の通りです。

・GPU(GeForce、RTXシリーズ):ゲーム・映像処理用

・データセンター向けGPU(A100、H100など):AI学習・推論用

・自動運転向けプラットフォーム(NVIDIA DRIVE)

・AIスーパーコンピューター(DGXシリーズ)

特に「H100 GPU」は生成AIの学習に必須とされ、MicrosoftやGoogleなど世界的クラウド企業が大量に導入しています。

NVIDIAが「AIインフラ企業」と呼ばれる理由

ゲーム用GPUからAI・データセンターへ進化

NVIDIAはもともとゲーマー向けのGPU市場で成長しましたが、今や売上の中心は「AI・データセンター」です。AI企業や研究機関が導入するスーパーコンピューターの多くにNVIDIA製GPUが採用されています。

この変化は「GPU=娯楽用部品」から「社会インフラの中核」への進化を意味します。

GPUの並列処理能力とCUDAエコシステム

NVIDIAのGPUは数万単位の演算を同時並列で処理できるため、AIの学習や大規模データ解析に最適です。

さらに、NVIDIAはハード性能だけでなく、CUDAを中心とした開発環境の充実度が強みとなっています。AI分野で使われる主要なフレームワーク(TensorFlow、PyTorchなど)はすべてNVIDIAに最適化されており、研究開発から実運用まで幅広く活用されています。

これにより、開発者・研究者は圧倒的に使いやすく、結果的に「NVIDIA一強」という市場構造を作り出しました。

GPU市場における圧倒的な市場シェア

NVIDIAはGPU市場で世界シェアの約80%を占め、特にAI分野では事実上の業界標準となっています。MicrosoftやGoogle、Amazonといったクラウド大手企業はもちろん、スタートアップから研究機関まで、幅広いユーザーがNVIDIA製GPUを利用しています。

この背景には、単なる「性能の高さ」だけでなく、エコシステム全体を支配しているという点があります。

NVIDIAが切り開く新しい市場と成長戦略

生成AIの爆発的普及

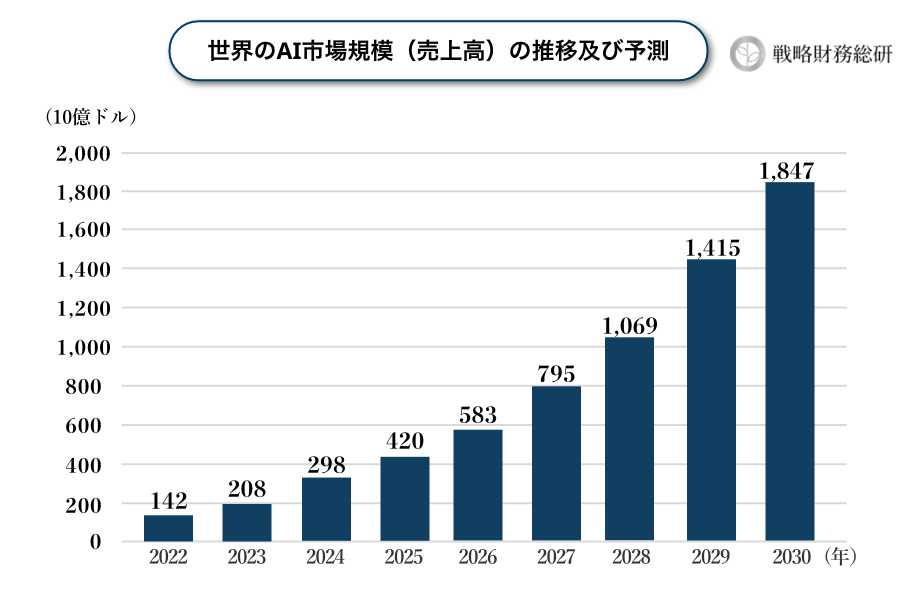

ChatGPTや画像生成AIなどの登場により、AI計算需要は爆発的に増加しました。これらのサービスを支えているのはNVIDIAのGPUであり、今後も需要は拡大し続けると予測されています。さらに、世界のAI市場規模(売上高)は、2030年まで加速度的成長が予測されています。

GPU市場の急成長と投資機会

世界のGPU市場は、2019年の約2,500億ドルから年平均20%以上で成長し、2025年には7,800億ドル規模に達すると予測されています。

成長の要因は以下の通りです。

- 生成AIの爆発的普及(ChatGPT、画像生成AI、LLMなど)

- クラウド事業者による大規模なGPU需要(Microsoft、Google、Amazonなど)

- 自動運転・IoT・エッジAIへの応用拡大

- 政府・企業による半導体開発への巨額投資

もはやGPUサーバーは「次世代の不動産」ともいえる存在になりつつあり、今がまさに投資の好機といえます。

NVIDIA製GPUサーバーの進化と世代ごとの特徴

AI最適化の始まり:Volta V100とTensor Core

AIの歴史において転換点となったのがVolta世代のV100です。

従来のGPUは行列演算に強みを持ちながらも、AI特化ではありませんでした。しかしV100から搭載されたTensor Coreは、ディープラーニングの演算を前提に設計された専用ユニットです。

- 行列積演算を高速処理でき、学習スピードが飛躍的に向上

- 単なるHPC用途を超え、AIモデル学習のためのGPUという位置づけを確立

この世代を機に、GPUは「AI研究の必須ツール」として認識され始め、世界中の研究機関・クラウド事業者に導入が進みました。

(参考)NVIDIA V100

推論時代を切り開いたTuring T4

次に登場したT4は、AI学習よりも「推論」処理にフォーカスした製品です。

T4はわずか70Wという省電力でありながら、INT8やFP16といった低精度演算に最適化されており、クラウドやエッジで大量導入されました。

- 音声認識、レコメンドシステム、チャットボットの基盤として普及

- 低コストで効率よくAI推論を行える点から、大手クラウド(AWS、GCP、Azure)が標準搭載

T4の登場は、AIを「研究用途」から「商用サービス」へと一気に普及させるきっかけとなりました。

(参考)NVIDIA T4

万能GPUとしての地位確立: Ampere A100

2020年に登場したAmpere A100は、それまでの「学習用」「推論用」の垣根を越えた万能GPUとして大きなインパクトを与えました。

- MIG(Multi-Instance GPU)で1台を7分割、複数ユーザー利用を可能に

- TF32 / BF16で精度と速度を両立

- スパース最適化でモデル圧縮と高速化に対応

A100はクラウドやデータセンターに大量導入され、BERTやGPT-3といった自然言語処理モデルの学習を支えました。これによりAIの民主化が進み、中小企業やスタートアップでも大規模AI活用が現実的になったのです。

生成AI時代の主役:Hopper H100/H200

2022年以降、生成AIが社会現象となる中、その中心を担ったのがHopper世代のH100です。

- Transformer Engineにより、大規模言語モデル(GPT-4など)を高速学習

- FP8演算で効率を倍増

- HBM3/HBM3eメモリでデータ転送速度を劇的に改善

2023年後半に登場したH200ではさらにHBM3eメモリを搭載し、メモリ帯域を拡大。これにより、数千億パラメータ規模の巨大モデルの学習が実用化されました。

特にH100 Tensorは、H100に搭載されたTensor Coreを最大限活用する構成を指し、生成AIやLLMの学習・推論において「必須インフラ」として世界的に需要が爆発しています。

次世代のAIインフラ:Blackwell B200/GB200

2024年に発表されたBlackwell世代製品は、AIデータセンターを次のステージへと押し上げます。

- FP4/FP6演算により、推論効率を大幅改善

- NVLink第5世代で超高速GPU間通信

- NVL72アーキテクチャで72基のGPUを1つの「巨大GPU」として稼働可能

これによりAIデータセンターは「AI工場」として進化し、汎用AI(AGI)の実現に向けた基盤が整いつつあります。

生成AIとメディア処理を両立する万能GPU:NVIDIA L40S

最新世代で注目されるのがNVIDIA L40Sです。

L40Sは、生成AIの推論処理と高性能グラフィックス処理を両立できる汎用GPUであり、以下の点で導入が進んでいます。

- H100ほど高額ではなく、中堅企業でも導入可能

- 生成AI推論に十分な性能を発揮しつつ、3DレンダリングやビジュアルAIにも対応

- データセンターの「AI導入の第一歩」として最適

L40SはH100のような超高性能学習専用ではありませんが、汎用性とコストパフォーマンスの高さから、幅広い分野で採用が広がっています。

(参考)NVIDIA L40S

NVIDIAのGPUは、Volta V100でAI最適化を開始し、T4で推論を普及、A100で万能化、H100/H200で生成AIの基盤を築き、Blackwell世代でAI工場時代へ突入しました。さらに、L40Sのような汎用GPUも登場し、用途に応じた選択肢が広がっています。

こうした世代の進化を理解することで、GPUサーバー投資の戦略を描きやすくなり、節税や事業成長の観点からも有効な意思決定が可能になります。

NVIDIAと他のGPUサーバーとの違い

ソフトウェアエコシステムの強さ

先述したように、NVIDIAは「CUDA」という独自の開発環境を提供しており、AI研究や産業利用における主要フレームワーク(TensorFlowやPyTorchなど)はほぼNVIDIA前提で最適化されています。一方、AMDやインテルのGPUは性能面で競争力を高めていますが、ソフトウェア対応が限定的なため、実際のプロジェクトではNVIDIAが選ばれるケースが圧倒的に多いのです。

性能・消費電力効率

NVIDIAの最新GPUは、AIモデルの学習速度で他社を大きく上回り、主要クラウド企業が優先的に導入しています。また、TSMC(世界最大の半導体受託製造企業)との強固な供給体制を持つため、長期的な安定供給が可能です。これも投資資産として安心感につながります。

資産価値と中古市場

GPUサーバーは減価償却資産ですが、中古市場でもNVIDIA製は高値で取引される傾向があります。需要が圧倒的に多いため、資産価値が落ちにくく、投資対象として有利に働きます。

投資対象としての安定性

- NVIDIA:エコシステム、供給体制、市場ニーズ → 長期的に安定した投資資産

- 他社GPU:成長余地はあるが、需要や運用環境の点で限定的 → 投資対象としては慎重判断が必要

GPUサーバー投資と節税効果

設備投資としての魅力

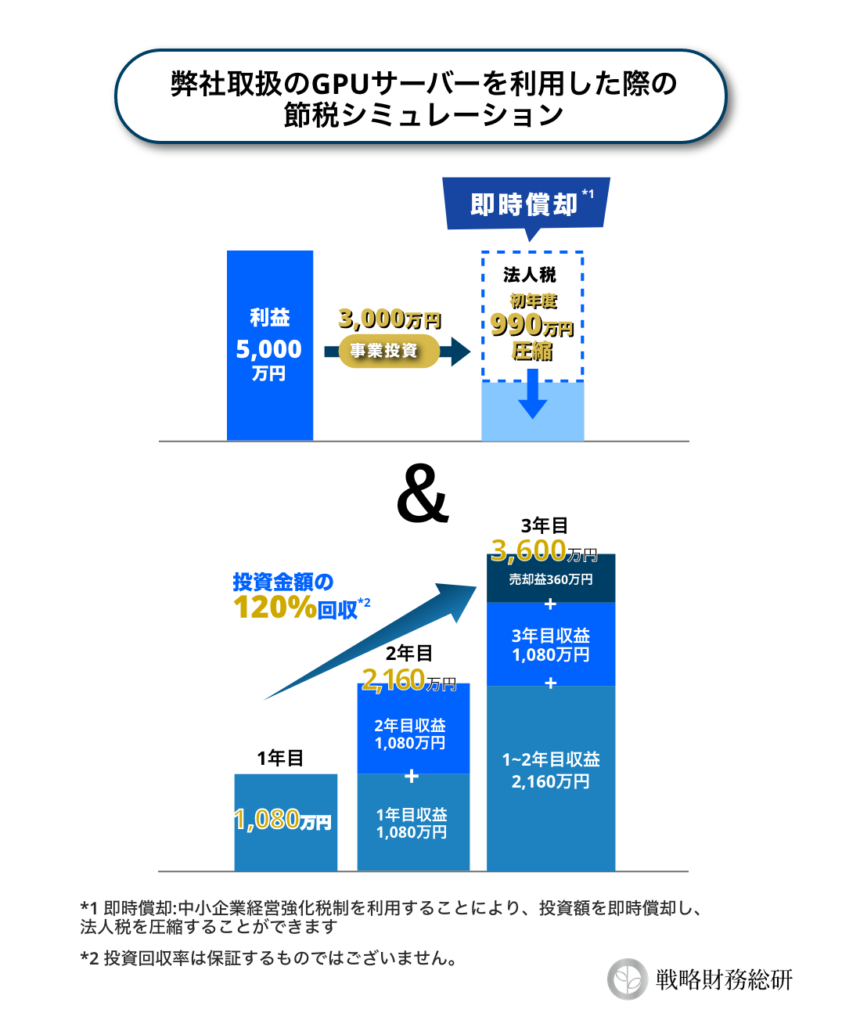

GPUサーバーは物理資産であり、会計上は設備投資として扱われます。中小企業経営強化税制を活用すれば、以下の優遇を受けることが可能です。

- 即時償却:購入した年度に全額を損金算入可能

- 税額控除:購入金額の7〜10%を法人税額から直接控除

この仕組みにより、GPUサーバー投資は「節税」と「事業成長」を同時に実現できるのです。

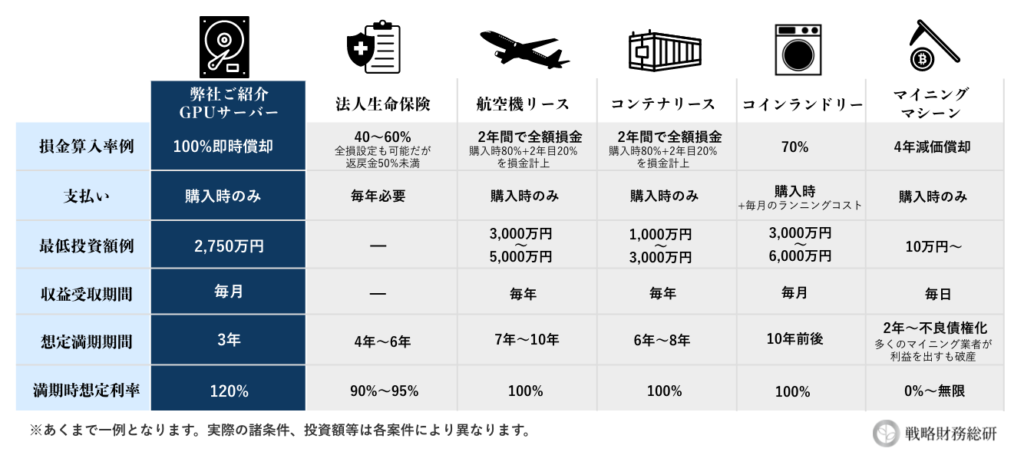

GPUサーバーは、今や世界中の研究開発・産業インフラ・クラウドサービスの基盤として急速に導入が進んでおり、次世代インフラ投資の中核として注目されており、他の繰延節税に比べて短期で高収益を期待できる事業となっております。特に、NVIDIAの最新GPUは世界的に供給が追いつかないほどの争奪戦となっています。

他の繰延節税との比較

生命保険や匿名組合型投資などの繰延節税は、運用を誤ると将来的に課税が戻るリスクがあります。一方、GPUサーバーは実体のある設備投資であり、税務調査でも否認されにくいというメリットがあります。

NVIDIA製GPUサーバー投資のシミュレーション例

弊社ではNVIDIA製のGPUサーバーを元にしたデータセンター事業のご紹介をしております。本事業では、購入費用を即時償却できる中小企業経営強化税制の対象となっているとともに、他の繰延節税に比べて短期で高収益を期待できる事業となっております。

詳しくは弊社コンサルタントよりご案内致しますので、お気軽にお問い合わせください。

よくある質問

Q1. 税務調査で、GPUサーバーを即時償却し一括で損金計上した場合、否認される可能性はありますか?

基本的には、そのような心配はありません。

これまでに、即時償却による一括損金計上が税務調査で否認された事例も発生しておりません。

なお、「中小企業経営強化税制」の認定を受けた資産については、原則として即時償却(一括損金計上)が可能です。

Q2.今後、市場のGPUの計算力の供給増加に伴い、価格競争によって事業収益が減少する可能性はありますか?

可能性として完全には否定できませんが、弊社がご案内するGPUサーバー投資では、継続的な市場調査に基づき、市場成長率および供給動向を総合的に考慮した結果、大幅な事業収益の減少は起こりにくいと判断しております。

また、複数の事業者との業務提携により、価格競争のリスクを最大限軽減できる体制を構築しています。

Q3. GPUサーバーが故障した場合の保証はありますか?

GPUサーバーの稼働開始日から3年以内に発生した、経年劣化による故障については、製造メーカーの無償保証の対象となります。

なお、火災・台風・地震などの自然災害による破損についてはメーカー保証の対象外ですが、保険会社にご加入いただくことで補償の対象となる可能性がございます。

詳しくは、個別相談会でお問い合わせください。

まとめ|NVIDIA時代の節税と投資チャンス

NVIDIAは、GPU市場において圧倒的なシェアと技術力を持ち、AI時代のインフラを支える企業です。その製品を活用したGPUサーバー投資は、世界的な需要拡大を背景に高収益を期待できると同時に、中小企業経営強化税制を通じた即時償却で大幅な節税効果も得られます。

「節税」と「成長投資」を両立させたい企業にとって、NVIDIA GPUサーバーは今後ますます重要な選択肢となるでしょう。AI時代の到来に備え、いまから戦略的に検討を進めることをおすすめします。

GPUサーバー投資について、詳しくはこちらの記事もご覧ください。

弊社では、NVIDIA製のGPUサーバーを元にしたデータセンター事業を活用した節税対策をご紹介をしております。購入費用を即時償却できる中小企業経営強化税制の対象となっているとともに、他の繰延節税に比べて短期で高収益を期待できる事業です。

ご興味のある方は、お気軽に個別相談会にご参加ください。

弁護士監修|税法遵守した対策のみご紹介

透明性の高い情報開示

継続的なフォローアップ体制

戦略税務総研では、GPUサーバー投資以外にも、

100%即時償却が可能で、数年の短期回収で130%超の回収率を実現した「ハイブリッド節税」をご紹介しております。

特別相談会ではハイブリッド節税の具体的なスキームや事業内容、収益予測など詳細をご案内しております。貴社の利益状況と課題に応じた最適な節税戦略を無料でご提案しています。

法人に加え経営者個人の節税対策もご支援しますので、まずはお気軽にお問合せください。

\節税のプロに相談/